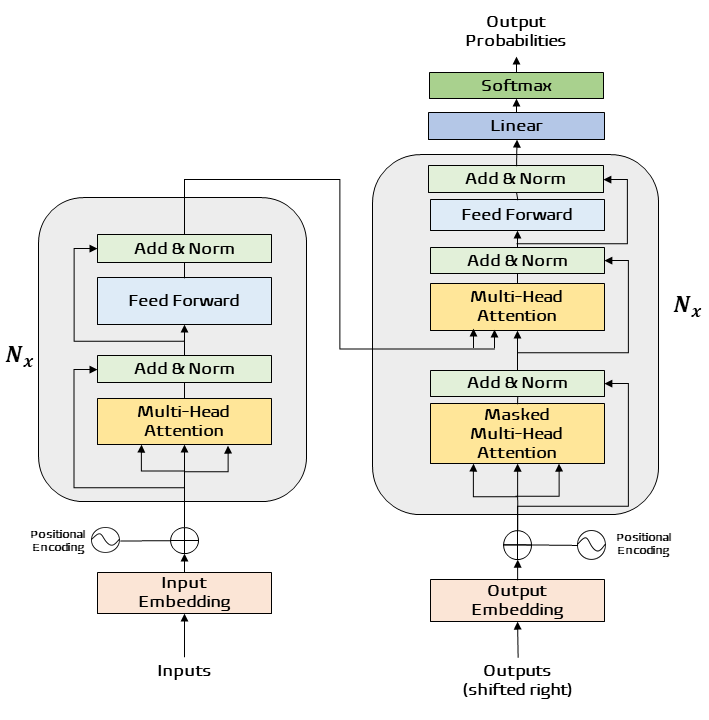

Bu yazı serimizde popüler bir yapay zeka modeli olan Transformer ağlarını detaylı olarak inceleyeceğiz.

Orijinal Transformer tanımı ilk defa 2017 yılında Vaswani ve arkadaşları tarafından yayınlanan Attention is All You Need makalesinde geçmektedir. Burada biz de bu makalede bahsedilen Transformer modelini temel alacağız.

Orijinal Transformer modeli üst üste binmiş 6 katmandan (layer) oluşur. l katmanının çıktısı son tahmine (final prediction) gelene kadar l+1 katmanının girdisidir.

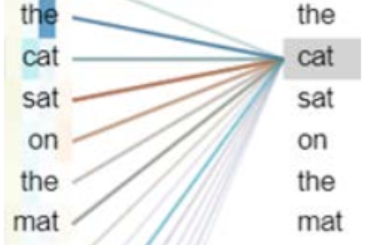

Transformer ile attention, recurrence(yineleme)’ın yerini almıştır. İki kelimenin arası arttıkça yineleme miktarının da artacağını düşünürsek bu hem işlem, hem de performans olarak aşırı yük getirecektir. Oysa attention mekanizması word-to-word bir işlemdir. Attention’ın temel amacı kelimenin diğer kelimelerle, kendisi de dahil olmak üzere nasıl bir ilişkisi olduğunu belirlemektir.

Aşağıdaki cümle üzerinden akışın nasıl ilerlediğini anlamaya çalışalım:

The cat sat on the mat.

Attention word vektörleri arasında dot product yapacak ve diğer tüm wordler arasındaki kendisi de dahil olmak üzere ilişkiyi ortaya koyacaktır.

Her bir attention altkatmanı (orijinal Transformer modeli için ) tek tek değil 8’li şekilde paralel olarak çalışır böylece hesaplamalar hızlanır. Bu işleme multi-head attention adı verilir.

Multi-head attention:

- Metin sekanslarının daha derinlemesine analizini

- Yinelemenin engellenerek hesaplama işlemlerinin azaltılmasını

- İşlemlerin paralel şekilde yapılarak eğitim zamanının düşürülmesini

- Her attention mekanizmasının aynı inputu farklı perspektifler ile öğrenmesini

sağlar.

Dipnot: Attention mekanizmasının recurrence(yineleme) yerine geçmesinin Transformer modelinin en büyük değişikliklerinden birisi olduğunu söyledik, ancak bu mimariyi çok daha efektif kılan başka özelliklerden de ileriki serilerimizde bahsedeceğiz. Transformer’ın sadece recurrence'(yineleme)ı yok ettiğini düşünmeyelim.

![]()